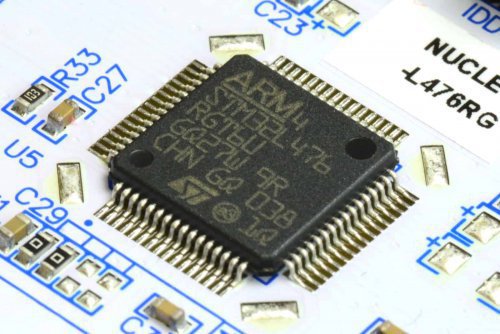

Który układ jest najlepszy na świecie? - STM czy nie STM, o to jest pytanie!

-

Quizy

-

Najnowsze posty w innych tematach

-

- 112 odp.

- 231 wyświetleń

-

- 2 odp.

- 31 wyświetleń

-

- 0 odp.

- 16 wyświetleń

-

- 4 odp.

- 115 wyświetleń

-

- 0 odp.

- 31 wyświetleń

-

Pomocna odpowiedź

Dołącz do dyskusji, napisz odpowiedź!

Jeśli masz już konto to zaloguj się teraz, aby opublikować wiadomość jako Ty. Możesz też napisać teraz i zarejestrować się później.

Uwaga: wgrywanie zdjęć i załączników dostępne jest po zalogowaniu!