Przeszukaj forum

Pokazywanie wyników dla tagów 'Freestyle'.

Znaleziono 165 wyników

-

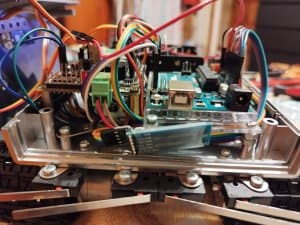

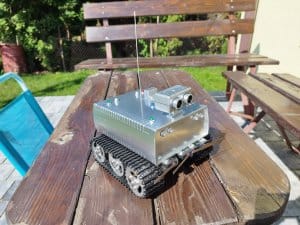

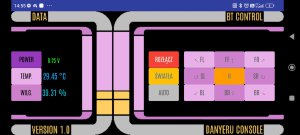

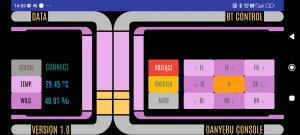

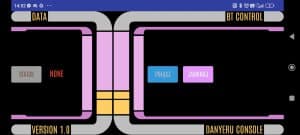

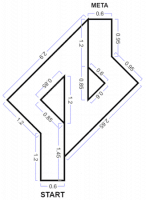

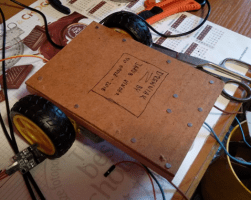

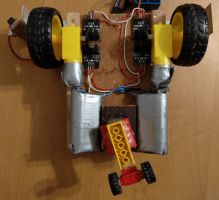

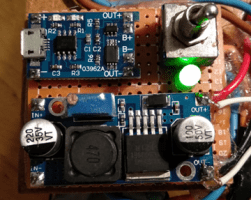

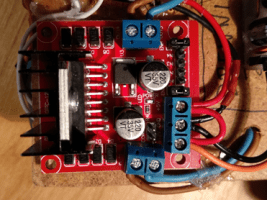

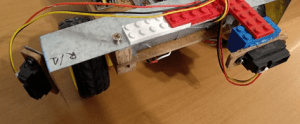

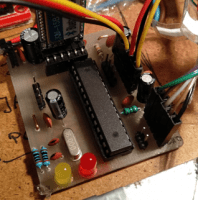

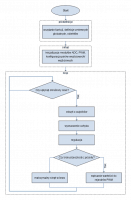

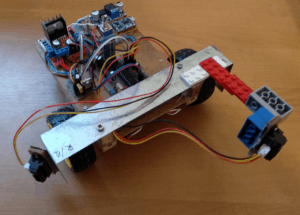

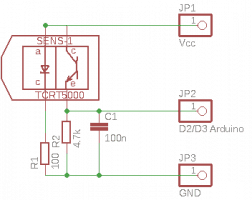

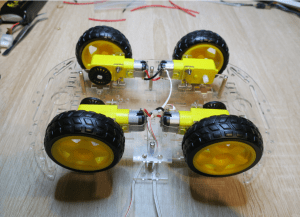

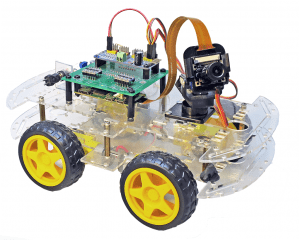

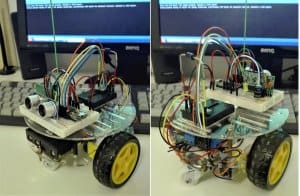

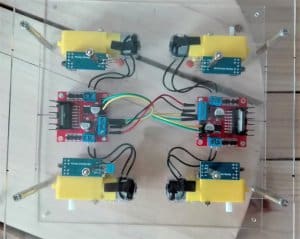

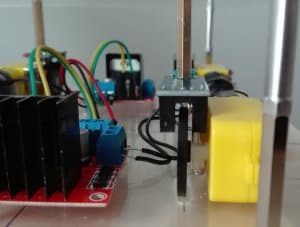

Cześć. 🙂 Przedstawiam wam Small Autonomous Amateur Rover "Romek" - czyli owoc mojej, z założenia kosmetycznej, metamorfozy robota, którego można poznać w jednym z forbotowych kursów. (A ponieważ robiłem tylko w wolnych chwilach, których wielu nie mam, to niczym ciąża - zacząłem z końcem listopada, mamy narodziny z końcem sierpnia). Krótki zarys historyczny: Kilka lat temu miałem fazę, zakupiłem w Botlandzie kilka zestawów do kursów oraz tu i ówdzie trochę rzeczy do szuflady "przydasiów". Życie jednak weryfikuje i przez kilka lat zbierało kurz, aż w zeszłym roku przeszedłem w końcu kurs budowy robotów i kurs Arduino poziom I. Jednak chciałem przede wszystkim sterować robotem przez BT, do tego chciałem pozbyć się w jakiś sposób wężykowania. Odnalazłem info, że komunikacja z BT to w zasadzie komunikacja przez port szeregowy - zapiąłem HC-05, zainstalowałem aplikację Bluetooth RC Car i napisałem switch case pod dane wysyłane z tej apki. Pierwsza rozbudowa "forbociaka" - moduł HC-05 i konwerter poziomów logicznych. Robot jeździł sterowany przez BT i tyle. Podjąłem decyzję, że dokonam modyfikacji zarówno w kodzie, jak i wyglądzie - z tym ostatnim poszedł też warunek, tylko rzeczy z szuflady, żadnych nowych inwestycji - własny czelendż ruszył. Posiadałem podwozie typu T100, które miało silniki z enkoderami - pomyślałem, że super, bo te silniczki z kursu to mogłyby mieć problem z ruszeniem cięższej konstrukcji, ponadto różny typ osi sprawił, że nawet nie próbowałem z nimi rzeźbić. Początkowa radość minęła wraz z przeczytaniem specyfikacji - maksymalny prąd pracy dołączonych silników to 4,5A, zdecydowanie za dużo na shield od Forbota. Przekopywałem szufladę dalej, znalazłem w niej silniczki N20, ale to maluszki, no i oś za mała. Znalazłem także silniki DFRobot o odpowiedniej osi i punktach montażowych. Przeczytałem notę - 7,5V, prąd pracy 50mA, maks. prąd 600 mA, przekładnia 99:1 - zostały wybrane. Nie chciałem mieć elektroniki na zewnątrz, więc potrzeba było też obudowy. Na wstępie wybrałem Kradex Z125 na body i Kradex Z130 na czujnik odległości. Jednak wraz z rozbudową, wybrana obudowa okazała się za ciasna - ledwo się zamykała, a nie założyłem jeszcze wszystkiego, co chciałem. Dodatkowo chciałem odzyskać pewne piny Arduino, które zajmował shield, a których nie potrzebowałem (przycisk i odbiornik IR). Podjąłem decyzję o zmianie obudowy - miałem jeszcze Kradex Z112, która była szersza i nieco wyższa. Poprzednia obudowa wchodziła pomiędzy gąsienice, przy tej musiałem zastosować dystanse, żeby zamocować budę do podwozia i nie kolidować z gąsienicami. Dodałem płaski koszyk na 6 baterii AA, krańcówki dla jazdy autonomicznej, połączone po dwie równolegle - żeby pokryć jak najwięcej czoła i jednocześnie nie odchylać blaszek pod dużym kątem i nie dodawać wąsów z trytytek - i wyłącznik kołyskowy, żeby załączać zasilanie z zewnątrz. Kanapkę Arduino+shield rozdzieliłem i połączyłem je przewodami, odzyskując wspomniane wcześniej piny cyfrowe 2 i 3 oraz uzyskując dostęp do pinu 3,3 V. Obudowę przed dalszymi pracami pomalowałem. Żeby robot nie był tylko sterowanym autkiem, dodałem oczywiście czujnik odległości HC04-SR, czujnik temperatury i wilgotności DHT22 oraz dzielnik napięcia - zbudowany z rezystora 510k i dwóch 68k - dla pomiaru napięcia baterii. Profesjonalny dzielnik amatorski. 😉 Na koniec dodałem LED-y w oprawkach. 4 białe jako światła czołowe, każdy z rezystorem 1k. 2 zielone i 2 czerwone jako światła pozycyjne/nawigacyjne - również z rezystorami 1k. 2 żółte drogowe (już nie żółte, jeszcze nie pomarańczowe) jako światła ostrzegawcze, oczywiście z rezystorami 1k. 1 niebieski jako światło sygnalizujące jazdę autonomiczną, z rezystorem 330 Ohm. Niebieski LED jest zasilany i załączany bezpośrednio z Arduino. Pozostałe LED-y zasilane są z baterii i załączane przez tranzystory NPN BC548. Ostatecznie wyszło trochę makaronu z przewodów, ale nie jest ciasno, obudowa zamyka się dobrze, a ja mam w razie W spis przewodów, a te z górnej części, które są wpięte w Arduino są także opisane na wtykach. :) Ponieważ żółte ledy miałem tylko typu clear i ich światło było widoczne tylko na wprost soczewki, dodałem dyfuzory zrobione ze... słomki. 😄 Romek po montażu waży ok. 1290 g i prezentuje się tak: Oprogramowanie: Założyłem, że chcę się pozbyć delay(), żeby nie kolidować z DHT oraz żeby robot reagował natychmiast na polecenia. Czasami musiałem się naklikać zanim robot zareagował. Czujnik odległości był jedną z prostszych rzeczy. Zastosowałem bibliotekę New Ping, dla której utworzyłem obiekt: NewPing sonar(trigPin, echoPin, MAX_DISTANCE); Sama funkcja wygląda tak: int sonarDystans() { int dystans = sonar.ping_cm(); // Wykonanie pomiaru i zapisanie wyniku w zmiennej distance w centymetrach return dystans; } A jej wykorzystanie na przykład tak: if (sonarDystans() <= doPrzeszkody) { //Jeżeli w zadanej odległości jest przeszkoda obecnyStan = ZATRZYMAJ; //Przejdź do zatrzymania czasStanu = millis(); //Ustaw czas dla timera serwo.attach(SERWO_PIN); //Podłącz serwo } Najwięcej problemów miałem z przepisaniem logiki jazdy autonomicznej. Poziom mojej wiedzy to kurs robota, kurs Arduino I i na coś tam liźnięte o DHT i millisach. Tutaj nawet zatrudniłem forumowiczów do pomocy: Ostatecznie oryginalną logikę wymieniłem na maszynę stanów, gdzie w danym stanie wywołuję funkcję, a dopiero w funkcji mam opisane zachowanie robota. switch (obecnyStan) { case PROSTO: prosto(); break; case ZATRZYMAJ: zatrzymaj(); break; void zatrzymaj() { zatrzymajSilniki(); if (millis() - czasStanu >= 500UL) { //Odczekaj zadany czas obecnyStan = PATRZ_PRAWO; //Przejdź do wykrywania przeszkody po prawej czasStanu = millis(); } } W przypadku krańcówek musiałem dodać flagę dla kolizji, gdyż bez tego po wjechaniu w przeszkodę robot się zatrzymywał. Zapewne zanim zdążył przejść dalej program ponownie docierał do miejsca, gdzie natrafiał co zrobić po załączeniu krańcówki. Dodanie flagi sprawiło, że problem zniknął. boolean kolizjaPrawo = false; if (digitalRead(prawySensor) == LOW && kolizjaPrawo==0) { //Jeżeli przeszkoda po prawej kolizjaPrawo = 1; obecnyStan = COFAJ_PRAWY; czasStanu = millis(); } void cofajPrawy() { lewySilnik(-70); prawySilnik(-70); if (millis() - czasStanu >= 800UL) { obecnyStan = ZATRZYMAJ2; //Przejdź do wykrywania przeszkody po prawej czasStanu = millis(); kolizjaPrawo = 0; } } Samo wejście w jazdę autonomiczną również realizowane jest zmianą flagi. W switch case dle odczytu z seriala/BT poczyniłem toggleswitch. case 'A': jazdaAutonomiczna = !jazdaAutonomiczna; if (!jazdaAutonomiczna) { zatrzymajSilniki(); ekspander.digitalWrite(LEDjazda, 0); serwo.detach(); } break; Nie ukrywam, że obsługę DHT podejrzałem w drugiej części kursu do Arduino, zanim tam dotrę, ale jak już wiemy, unikam delay(). Na podstawie obsługi czujnika z kursu i tego co wiem o millisach, napisałem funkcję po swojemu. Dodałem też korektę odczytów, gdyż względem czujnika referencyjnego temperatura była zawyżana o wilgotność zaniżana. Najpierw próbowałem korekty procentowej, ale ostatecznie wprowadziłem sztywną korektę. Względem czujnika referencyjnego odczyty nie odbiegają o więcej niż 0,5 stopnia i 0,5%. W tym miejscu dodałem także odczyt z ADC, gdzie doprowadziłem wyjście z dzielnika napięcia dla baterii. Dla napięcia baterii 9,66 V napięcie doprowadzone z dzielnika wynosiło ok. 0,95 V. Po wstępnym obliczeniu mnożnika, ostateczną wartość dobrałem empirycznie. Rozbieżność nie przekracza 0,1 V, średnio jest to 0,06 V. W funkcji tej następuje także wysyłanie danych na serial. void humitemp () { //Funkcja czujnika DHT22 i pomiar napięcia float wilgotnosc = dht.getHumidity(); //Pobierz info o wilgotności do zmiennej float temperatura = dht.getTemperature(); //Pobierz info o temperaturze do zmiennej float wilgKorekta = wilgotnosc + 1.11; //Korekta dla odczytu wilgotności float tempKorekta = temperatura - 2.35; //Korekta odczytu temperatury int adc_val = analogRead(bateria); //Odczytaj wartość ADC float Ubat = adc_val * 0.0485340314; //Wylicz wartość napięcia czasDHT = millis(); //Pobierz aktualny czas Arduino roznicaDHT = czasDHT - odmierzDHT; if (roznicaDHT >= 2000UL) { //Jeżeli różnica wyniesie 2000 ms lub więcej odmierzDHT = czasDHT; //Zapisz aktualny czas arduino do zmiennej if (dht.getStatusString() == "OK") { //Jeżeli czujnik zwróci wartość ok, wykonaj poniższe Serial.print(tempKorekta); Serial.print(" °C"); Serial.print("|"); Serial.print(wilgKorekta); Serial.print(" %"); Serial.print("|"); Serial.print(Ubat); Serial.println(" V"); } } } Wspomniałem wcześniej, że odzyskałem niektóre piny z Arduino. Zależało mi zwłaszcza na pinie PWM dla świateł pozycyjnych. W prototypie używałem pinu ekspandera w trybie włącz-wyłącz, a pulsowanie osiągałem przez zastosowany kondensator, jednak nie dawało to pełnej kontroli. Uwolniony pin PWM wykorzystałem właśnie do świateł pozycyjnych. Zmienna kierunek ma wartość 1 lub -1, zatem wartość PWM jest zwiększana lub zmniejszana. Kiedy wartość PWM osiąga 0 lub 255 wartość zmiennej kierunek zostaje przemnożona przez -1 powodując zmianę jej wartości na przeciwną. void swiatlaPuls() { aktualnyCzasPWM = millis(); // Obsługa narastania i opadania PWM if (aktualnyCzasPWM - poprzedniCzasPWM >= interwalZmianyPWM) { poprzedniCzasPWM = aktualnyCzasPWM; wartoscPWM += kierunek; //Zmniana wartości PWM zależna od wartości kiereunku if (wartoscPWM >= 255 || wartoscPWM <= 0) { if (aktualnyCzasPWM - poprzedniCzasAnimacji >= interwalZmianyKierunku) { poprzedniCzasAnimacji = aktualnyCzasPWM; kierunek *= -1; // Zmiana kierunku narastania/opadania } } analogWrite(pulsLED, wartoscPWM); } } Dla świateł ostrzegawczych chciałem osiągnąć efekt szybkich mignięć wplecionych we włączanie i wyłączanie (włącz, zapulsuj, wyłącz, powtórz). Pożądane zachowanie uzyskałem stosując switch case i zmienną dla licznika i zmieniając zachowanie świateł w zależności od jej wartości. void swiatlaStrobo() { czasLEDstrobo = millis(); switch(licznikStrobo) { case 0: digitalWrite(stroboLED, 1); if (czasLEDstrobo - czasStrobo >= 700UL) { digitalWrite(stroboLED, 0); czasStrobo = czasLEDstrobo; licznikStrobo ++; } break; case 13: digitalWrite(stroboLED, 0); if (czasLEDstrobo - czasStrobo >= 500UL) { digitalWrite(stroboLED, 0); licznikStrobo ++; } break; default: if (czasLEDstrobo - czasStrobo >= 50UL) { czasStrobo = czasLEDstrobo; stanStrobo = !stanStrobo; digitalWrite(stroboLED, stanStrobo); licznikStrobo ++; } break; } if (licznikStrobo > 13) { licznikStrobo = 0; } } Na koniec moja świeżynka. Poznałem operator trójargumentowy, zauważyłem, że dla mnie - tego amatora przed monitorem - działa podobnie do if else, zatem przepisałem logikę odpowiedzialną za silniki. Dotychczas używałem oryginalnej z kursu, po poznaniu tego operatora powstało coś takiego: void lewySilnik (int VL) { if (VL == 0) return; //Jeżeli wartość VL jest równa zero to nie wykonuj funkcji int kierunekLewySilnik = (VL > 0) ? 0 : 1; //Jeżeli wartość VL jest większa od 0 to ustaw wartość 0 (jazda do przodu), jeżeli mniej to ustaw 1 (do tyłu) int vlMap = map(abs(VL), 0, 100, 0, PWM_MAX); //Przemapuj zakres PWM do zakresu 0-100, dla ujemnego VL zwróć wartość absolutną digitalWrite(L_DIR, kierunekLewySilnik); //Jazda do przodu, albo do tyłu :) analogWrite(L_PWM, vlMap); //Ustaw zadaną prędkość } Komunikacja - software: Robot jest częściowo zgodny z aplikacją o której wspomniałem na początku (sterowanie, załączanie świateł co drugi kllik), ale gotowa apka nie do końca spełnia moje oczekiwania. Można też sterować przez aplikację typu BT serial monitor, ale to też nie do końca to - choć tutaj już odbieram dane. Postanowiłem wyrzeźbić - to dobre słowo - aplikację w APP Inventorze. O ile w sekcji bloczkowej jakoś to poszło, to graficznie naprawdę była to rzeźba. Predefiniowane rozdzielczości są przedpotopowe, a i responsive nie do końca daje to, czego człowiek oczekuje. Ale, potrzebowałem jednej apki, więc postanowiłem się przemęczyć, zamiast podejmować naukę tworzenia od podstaw w jakimś ludzkim środowisku. W pierwszej wersji odbierałem temperaturę i wilgotność, napis "connect" był tylko etykietą. W drugiej odbieram jeszcze wartość napięcia. Przyciski kierunkowe to przód, tyłu, obroty w miejscu w prawo, w lewo. Dodatkowo w narożnikach przyciski przywołują jazdę po łuku w daną stronę (prawy przód, lewy tył itp). Przycisk H wyzwala impuls buzzerem. Przycisk Światła uruchamia światła. Zmienna w robocie sprawia, że po kolei uruchamiane są: światła pozycyjne i ostrzegawcze, z drugim wywołaniem dochodzą światła frontowe, z trzecim wywołaniem gaszone są pozycyjne i ostrzegawcze, pozostają frontowe. Czwarte wywołanie resetuje zmienną i gasi wszystkie światła. Przycisk Auto włącza lub wyłącza tryb jazdy autonomicznej. Podsumowanie Zdaję sobie sprawę, że kod nie jest idealny, zwłaszcza, że wiele rzeczy znałem po łebkach, niektórych uczyłem się w trakcie. Ale jestem zadowolony - coś, co miało być tylko dodaniem sterowania BT zmieniło się w duży jak dla mnie projekt, który robiony po godzinach ostatecznie działa. 😄 Co dalej? Wyciągnę zasilanie jakoś zasilanie na zewnątrz. Zastosowana obudowa sprawia, że aby ją odkręcić, muszę ściągać gąsienice w celu uzyskania dostępu do śrub. To ze zwykłej wymiany baterii, czy przyszłych zmian w oprogramowaniu, zamienia rutynę w procedurę. 😉 W drugiej części kursu Arduino widziałem czujnik ruchu, więc pewnie też go jakoś zatrudnię - zamysł taki, że w trybie auto będzie sobie oczekiwał i uruchamiał jazdę po wykryciu ruchu. A ponieważ szuflada zawiera jeszcze jednego HC-05, jakiegoś klona Nano i wyświetlacz OLED, mam w planie zrobić sprzętowy kontroler dla tego robota. 😄 Co to za antenka? To tylko ozdoba - zabieram Romka ze sobą na ERC w tym roku - będzie maskotką. 😄 Jaki koszt konwersji? Dla mnie żaden, jeżeli uznajemy, że co w szufladzie to 0 zł. Jeżeli ktoś by chciał iść w moje ślady, to myślę, że kilka stówek. Podwozie jest najdroższe. Ale jak już ktoś ma wydawać pieniądze na konwersję, to lepiej na budowę od podstaw i zrezygnować z tego shielda, na rzecz sterownika, który uciągnie silniki 4,5A - wtedy nie trzeba szukać silników, które ogarnie shield i parę zł zostaje. 😉 Osobiście, gdyby nie postanowienie zrobienia tego bez dodatkowych nakładów, to pewnie też bym dokupił kilka rzeczy, rezygnując z shielda forbotowego, ale czelendż to czelendż. Dotarłeś tutaj? No to zobacz krótki filmik. 🙂 Podjazd miał nachylenie ok. 30 stopni. A tutaj cały potworek 😅 //Załączenie bibliotek #include "DHT.h" //Czujnik temperatury i wilgotności #include "Servo.h" #include "Adafruit_MCP23008.h" //Ekspander portów #include <NewPing.h> //Obsługa HC-SR04 //Ekspander Adafruit_MCP23008 ekspander; //Deklaracje i zmienne dla DHT i pomiaru napięcia #define DHT22_PIN 7 //Pin sygnału z DHT DHT dht; //Utworzenie obiektu dla czujnika #define bateria A3 unsigned long czasDHT = 0; unsigned long odmierzDHT = 0; unsigned long roznicaDHT = 0; //Deklaracje serwomechanizmu Servo serwo; #define SERWO_PIN 11 //Pin sygnału sterującego PWM int idle = 84; //Neutralna pozycja dla serwa //Deklaracje mostek H #define L_PWM 5 //Pin prędkości lewego silnika #define L_DIR 4 //Pin kierunku lewego silnika #define R_PWM 6 //Pin prędkości prawego silnika #define R_DIR 9 //Pin kierunku prawego silnika #define PWM_MAX 210 //Maksymalne wypełnienie dla silnika 7,5V przy zasilaniu 9V //Deklaracje i definicje do obsługi buzzera #define BUZZER 10 unsigned long aktualnyCzasBuzzer = 0; unsigned long czasStartuBuzzer = 0; unsigned long czasTrwaniaBuzzer = 200; // Czas trwania impulsu w milisekundach boolean buzzerON = false; //Deklaracje i zmienne czujnika odległości i wykrywania przeszkód #define LEDjazda 0 //LED informujący o jeździe autonomicznej na 0 pinie ekspandera!!! #define lewySensor A0 //Krańcówka po lewej #define prawySensor A1 //Krańcówka po prawej #define trigPin 12 //Pin nadawczy (szary) #define echoPin 13 //Pin odbiorczy (biały) #define MAX_DISTANCE 200 // Maksymalny zasięg w centymetrach NewPing sonar(trigPin, echoPin, MAX_DISTANCE); //Inicjalizacja obiektu sonar z użyciem biblioteki NewPing const int doPrzeszkody = 25; //Odległość wykrywania przeszkody w cm //Wyliczenie stanów dla jazdy autonomicznej enum States { PROSTO, PATRZ_PRAWO, OBROT_PRAWO, PATRZ_LEWO, OBROT_LEWO, ZATRZYMAJ, ZATRZYMAJ2, COFAJ, COFAJ_LEWY, COFAJ_PRAWY, }; boolean jazdaAutonomiczna = false; boolean kolizjaPrawo = false; boolean kolizjaLewo = false; static States obecnyStan = PROSTO; //Domyślny stan unsigned long czasStanu = 0; //Zmienna dla timera stanu unsigned long czasDotyku = 0; //Zmienna dla timera krańcówek static unsigned long czasObrotu = 1100; //Zmienna dla czasu trwania obrotu //Definicje i zmienne dla świateł #define frontLED 1 //LEDy frontowe na 1 pinie ekspandera!!! #define stroboLED 2 #define pulsLED 3 int trybLED = 0; unsigned long czasStrobo = 0; unsigned long czasLEDstrobo = 0; int stanStrobo = 0; int licznikStrobo = 0; int stanPuls = 0; unsigned long poprzedniCzasPWM = 0; unsigned long poprzedniCzasAnimacji = 0; int wartoscPWM = 0; int kierunek = 1; // 1 - narastanie, -1 - opadanie unsigned long interwalZmianyPWM = 10; unsigned long interwalZmianyKierunku = 750; unsigned long aktualnyCzasPWM = 0; void setup() { //Konfiguracja ekspandera ekspander.begin(); ekspander.pinMode(LEDjazda, OUTPUT); //Konfiguracja świateł ekspander.digitalWrite(LEDjazda, LOW); pinMode(stroboLED, OUTPUT); digitalWrite(stroboLED, stanStrobo); pinMode(pulsLED, OUTPUT); analogWrite(pulsLED, stanPuls); ekspander.pinMode(frontLED, OUTPUT); ekspander.digitalWrite(frontLED, LOW); //Konfiguracja pinów mostka H pinMode(L_DIR, OUTPUT); pinMode(L_PWM, OUTPUT); pinMode(R_DIR, OUTPUT); pinMode(R_PWM, OUTPUT); //Konfiguracja pozostałych elementów pinMode(bateria, INPUT); //Odczyt ADC dla pomiaru napięcia baterii pinMode(lewySensor, INPUT_PULLUP); pinMode(prawySensor, INPUT_PULLUP); Serial.begin(9600); //Uruchomienie sprzętowej komunikacji UART dht.setup(DHT22_PIN); //Podłączenie czujnika do zadeklarowanego pinu serwo.attach(SERWO_PIN); //Podłączenie serwa do zadeklarowanego pinu serwo.write(idle); //Ustawienie serwa w domyślnej pozycji delay(200); //Opóźnienie dla ustabilizowania i przeczekania stanów nieustalonych serwo.detach(); //Odłączenie serwa //Konfiguracja buzzera i info o zakończeniu setupu pinMode(BUZZER, OUTPUT); digitalWrite(BUZZER, 1); ekspander.digitalWrite(LEDjazda, 1); delay(100); digitalWrite(BUZZER, 0); ekspander.digitalWrite(LEDjazda, 0); delay(100); digitalWrite(BUZZER, 1); ekspander.digitalWrite(LEDjazda, 1); delay(100); digitalWrite(BUZZER, 0); ekspander.digitalWrite(LEDjazda, 0); delay(100); } void loop() { humitemp(); //Wykonuj funkcje DHT if(jazdaAutonomiczna) { jazdaAuto(); } switch (trybLED) { case 0: analogWrite(pulsLED, 0); digitalWrite(stroboLED, 0); ekspander.digitalWrite(frontLED, 0); break; case 1: swiatlaPuls(); swiatlaStrobo(); ekspander.digitalWrite(frontLED, 0); break; case 2: swiatlaPuls(); swiatlaStrobo(); swiatlaFront(); break; case 3: analogWrite(pulsLED, 0); digitalWrite(stroboLED, 0); swiatlaFront(); break; case 4: trybLED = 0; break; } if (buzzerON) { klakson(); } if (Serial.available() > 0) { //Jeżeli są dostępne dane BT char jazda = Serial.read(); //Odczytaj te dane i przypisz do zmiennej switch(jazda) { //Wykonaj case zgodnie z odebranymi danymi case 'F': //Do przodu lewySilnik(95); prawySilnik(95); break; case 'B': //Do tyłu lewySilnik(-95); prawySilnik(-95); break; case 'S': //Zatrzymaj zatrzymajSilniki(); break; case 'L': //Obrót w lewo lewySilnik(-80); prawySilnik(80); break; case 'R': //Obrót w prawo lewySilnik(80); prawySilnik(-80); break; case 'G': //Lewy łuk do przodu lewySilnik(60); prawySilnik(95); break; case 'I': //Prawy łuk do przodu lewySilnik(95); prawySilnik(60); break; case 'H': //Lewy łuk do tyłu lewySilnik(-60); prawySilnik(-95); break; case 'J': //Prawy łuk do tyłu lewySilnik(-95); prawySilnik(-60); break; case 'V': //Impuls buzzerem buzzerON = !buzzerON; czasStartuBuzzer = millis(); break; case 'X': trybLED++; break; case 'A': jazdaAutonomiczna = !jazdaAutonomiczna; if (!jazdaAutonomiczna) { zatrzymajSilniki(); ekspander.digitalWrite(LEDjazda, 0); serwo.detach(); } break; } } } void lewySilnik (int VL) { if (VL == 0) return; //Jeżeli wartość VL jest równa zero to nie wykonuj funkcji int kierunekLewySilnik = (VL > 0) ? 0 : 1; //Jeżeli wartość VL jest większa od 0 to ustaw wartość 0 (jazda do przodu), jeżeli mniej to ustaw 1 (do tyłu) int vlMap = map(abs(VL), 0, 100, 0, PWM_MAX); //Przemapuj zakres PWM do zakresu 0-100, dla ujemnego VL zwróć wartość absolutną digitalWrite(L_DIR, kierunekLewySilnik); //Jazda do przodu, albo do tyłu :) analogWrite(L_PWM, vlMap); //Ustaw zadaną prędkość } void prawySilnik (int VR) { if (VR == 0) return; //Jeżeli wartość VL jest równa zero to nie wykonuj funkcji int kierunekLewySilnik = (VR > 0) ? 1 : 0; //Jeżeli wartość VR jest większa od 0 to ustaw wartość 1 (jazda do przodu), jeżeli mniej to ustaw 0 (do tyłu) int vrMap = map(abs(VR), 0, 100, 0, PWM_MAX); //Przemapuj zakres PWM do zakresu 0-100 digitalWrite(R_DIR, kierunekLewySilnik); //Jazda do przodu, albo do tyłu :) analogWrite(R_PWM, vrMap); //Ustaw zadaną prędkość } void zatrzymajSilniki() { analogWrite(L_PWM, 0); //Zatrzymaj lewy silnik analogWrite(R_PWM, 0); //Zatrzymaj prawy silnik } void humitemp () { //Funkcja czujnika DHT22 i pomiar napięcia float wilgotnosc = dht.getHumidity(); //Pobierz info o wilgotności do zmiennej float temperatura = dht.getTemperature(); //Pobierz info o temperaturze do zmiennej float wilgKorekta = wilgotnosc + 1.11; //Procentowa korekta dla odczytu wilgotności float tempKorekta = temperatura - 2.35; //Korekta odczytu temperatury int adc_val = analogRead(bateria); //Odczytaj wartość ADC float Ubat = adc_val * 0.0485340314; //Wylicz wartość napięcia czasDHT = millis(); //Pobierz aktualny czas Arduino roznicaDHT = czasDHT - odmierzDHT; if (roznicaDHT >= 2000UL) { //Jeżeli różnica wyniesie 2000 ms lub więcej odmierzDHT = czasDHT; //Zapisz aktualny czas arduino do zmiennej if (dht.getStatusString() == "OK") { //Jeżeli czujnik zwróci wartość ok, wykonaj poniższe Serial.print(tempKorekta); Serial.print(" °C"); Serial.print("|"); Serial.print(wilgKorekta); Serial.print(" %"); Serial.print("|"); Serial.print(Ubat); Serial.println(" V"); } } } int sonarDystans() { int dystans = sonar.ping_cm(); // Wykonanie pomiaru i zapisanie wyniku w zmiennej distance w centymetrach return dystans; } void swiatlaPuls() { aktualnyCzasPWM = millis(); // Obsługa narastania i opadania PWM if (aktualnyCzasPWM - poprzedniCzasPWM >= interwalZmianyPWM) { poprzedniCzasPWM = aktualnyCzasPWM; wartoscPWM += kierunek; //Zmniana wartości PWM zależna od wartości kiereunku if (wartoscPWM >= 255 || wartoscPWM <= 0) { if (aktualnyCzasPWM - poprzedniCzasAnimacji >= interwalZmianyKierunku) { poprzedniCzasAnimacji = aktualnyCzasPWM; kierunek *= -1; // Zmiana kierunku narastania/opadania } } analogWrite(pulsLED, wartoscPWM); } } void swiatlaStrobo() { czasLEDstrobo = millis(); switch(licznikStrobo) { case 0: digitalWrite(stroboLED, 1); if (czasLEDstrobo - czasStrobo >= 700UL) { digitalWrite(stroboLED, 0); czasStrobo = czasLEDstrobo; licznikStrobo ++; } break; case 13: digitalWrite(stroboLED, 0); if (czasLEDstrobo - czasStrobo >= 500UL) { digitalWrite(stroboLED, 0); licznikStrobo ++; } break; default: if (czasLEDstrobo - czasStrobo >= 50UL) { czasStrobo = czasLEDstrobo; stanStrobo = !stanStrobo; digitalWrite(stroboLED, stanStrobo); licznikStrobo ++; } break; } if (licznikStrobo > 13) { licznikStrobo = 0; } } void swiatlaFront() { ekspander.digitalWrite(frontLED, 1); } void jazdaAuto() { //Funkcja jazdy autonomicznej ekspander.digitalWrite(LEDjazda, 1); //Włącz LED informujący o jeździe autonomicznej switch (obecnyStan) { case PROSTO: prosto(); break; case ZATRZYMAJ: zatrzymaj(); break; case ZATRZYMAJ2: zatrzymaj2(); break; case PATRZ_PRAWO: //Wykrywanie przeszkód po prawej patrzPrawo(); break; case OBROT_PRAWO: //Skręt w prawo obrotPrawo(); break; case PATRZ_LEWO: //Wykrywanie przeszkód po lewej patrzLewo(); break; case OBROT_LEWO: //Skręt w lewo obrotLewo(); break; case COFAJ: cofaj(); break; case COFAJ_LEWY: cofajLewy(); break; case COFAJ_PRAWY: cofajPrawy(); break; } if (digitalRead(lewySensor) == LOW && kolizjaLewo==0) { //Jeżeli przeszkoda po lewej kolizjaLewo = 1; obecnyStan = COFAJ_LEWY; czasStanu = millis(); } if (digitalRead(prawySensor) == LOW && kolizjaPrawo==0) { //Jeżeli przeszkoda po prawej kolizjaPrawo = 1; obecnyStan = COFAJ_PRAWY; czasStanu = millis(); } } void prosto() { if (sonarDystans() <= doPrzeszkody) { //Jeżeli w zadanej odległości jest przeszkoda obecnyStan = ZATRZYMAJ; //Przejdź do zatrzymania czasStanu = millis(); //Ustaw czas dla timera serwo.attach(SERWO_PIN); //Podłącz serwo } else { //Jedź prosto lewySilnik(90); prawySilnik(90); } } void zatrzymaj() { zatrzymajSilniki(); if (millis() - czasStanu >= 500UL) { //Odczekaj zadany czas obecnyStan = PATRZ_PRAWO; //Przejdź do wykrywania przeszkody po prawej czasStanu = millis(); } } void zatrzymaj2() { zatrzymajSilniki(); if (millis() - czasStanu >= 500UL) { obecnyStan = PATRZ_LEWO; //Przejdź do wykrywania przeszkody po prawej czasStanu = millis(); } } void patrzPrawo() { serwo.write(25); //Ustw serwo w prawo if (millis() - czasStanu >= 400UL) { //Patrz przez zadany czas dla ustabilizowania serwa if (sonarDystans() > doPrzeszkody) { //Jeżeli nie ma przeszkód bliżej niż zadana odległość obecnyStan = OBROT_PRAWO; //Skręć w prawo czasStanu = millis(); //Ustaw czas dla timera } else { //Jeżeli jest przeszkoda obecnyStan = PATRZ_LEWO; //Przejdź do wykrywania przeszkody po lewej czasStanu = millis(); //Ustaw czas dla timera } } } void obrotPrawo() { lewySilnik(70); prawySilnik(-70); serwo.write(idle); //Ustaw serwo na wprost if (millis() - czasStanu >= czasObrotu) { //Skręcaj przez zadany czas serwo.detach(); obecnyStan = PROSTO; //Przejdź do jazdy na prosto czasStanu = millis(); //Ustaw czas dla timera } } void patrzLewo() { serwo.write(155); //Obróć serwo w lewo if (millis() - czasStanu >= 450UL) { //Patrz przez zadany czas dla ustabilizowania serwa if (sonarDystans() > doPrzeszkody) { //Jeżeli nie ma przeszkody w zadanej odległości obecnyStan = OBROT_LEWO; //Skręć w lewo czasStanu = millis(); //Ustaw czas dla timera } else { //Jeżeli jest przeszkoda obecnyStan = COFAJ; //Włącz alarm czasStanu = millis(); //Ustaw czas dla timera } } } void obrotLewo() { lewySilnik(-70); prawySilnik(70); serwo.write(idle); //Ustaw serwo na wprost if (millis() - czasStanu >= czasObrotu) { //Skręcaj przez zadany czas serwo.detach(); obecnyStan = PROSTO; //Przejdź do jazdy prosto czasStanu = millis(); //Ustaw czas dla timera } } void cofaj() { serwo.write(idle); //Ustaw serwo na wprost lewySilnik(-80); //cofaj prawySilnik(-80); if (millis() - czasStanu >= 800UL) { //Po upływie zadanego czasu zatrzymajSilniki(); //Zatrzymaj się obecnyStan = ZATRZYMAJ; //Przejdź do jazdy prosto czasStanu = millis(); //Ustaw czas dla timera } } void cofajLewy() { lewySilnik(-70); prawySilnik(-70); if (millis() - czasStanu >= 800UL) { obecnyStan = ZATRZYMAJ; //Przejdź do wykrywania przeszkody po prawej czasStanu = millis(); kolizjaLewo = 0; } } void cofajPrawy() { lewySilnik(-70); prawySilnik(-70); if (millis() - czasStanu >= 800UL) { obecnyStan = ZATRZYMAJ2; //Przejdź do wykrywania przeszkody po prawej czasStanu = millis(); kolizjaPrawo = 0; } } void klakson() { aktualnyCzasBuzzer = millis(); if (aktualnyCzasBuzzer - czasStartuBuzzer < czasTrwaniaBuzzer) { digitalWrite(BUZZER, HIGH); } else { digitalWrite(BUZZER, LOW); buzzerON = false; } }

- 3 odpowiedzi

-

- 10

-

-

Freestyle Robot pubga v1.0- czyli otto diy po mojemu

Leoneq opublikował temat w Projekty - DIY roboty

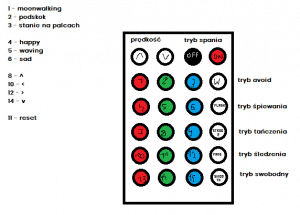

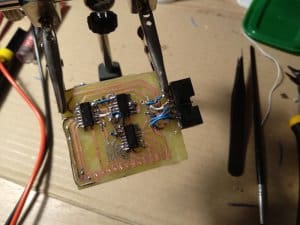

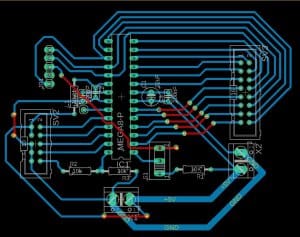

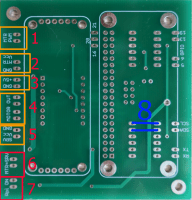

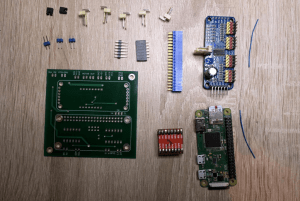

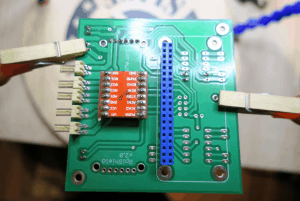

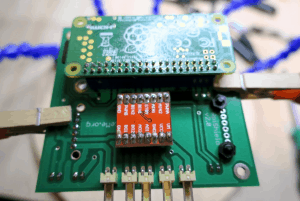

witam (do admina) na wstępie chciałem zaznaczyć, że jedyne co mam z gotowego projektu z neta to modele do wydrukowania (po co tworzyć coś na nowo jak już jest) jeżeli projekt nie zalicza się do akcji rabatowej, mogę usunąć linki i opublikować "po prostu". Był taki pomysł, żeby zbudować robota. Linefollower? jak już to na poważnie, a mi sie nie chce. Jakiś manipulator? nie mam napędów. Autko? to też chcę na poważnie zrobić, coś więcej niż lego. Wybór padł na robota, który miał po prostu zająć czymś kolegów i nauczycieli w szkole - czyli takie cudo na pokazy. Miało to być małe, do plecaka, znalazłem projekt otto diy. Spodobał mi się, więc wydrukowałem, złożyłem na płytce stykowej i ledwie zamknąłem obudowę przez kable 20cm - ale robot działał, wydawał zabawne odgłosy i tańczył. Zadanie swoje spełnił, mogłem go teraz zostawić i się skupić na zvsie (którego opublikuję po dokończeniu obudowy). Ale co to za skończony projekt na płytce stykowej? Nie mogłem tego tak zostawić, to dla mnie wręcz porażka. (Aby zapobiec spamowi, drukowałem na Aflawise U30 - dysza 0.4, chłodzenie petsfang, 60mm/s warstwa 0.3mm. PLA od printme, 200*C/60*C. Ta żółta czapka się źle wydrukowała, to troszkę uzupełniłem ubytki lutownicą i filamentem, co jak widać średnio wyszło.) Myślałem, czego mi w nim brakuje. Oczywiście sztuczki robota robione w kółko szybko się znudziły, to musiałem wymyślić jakieś sterowanie. Mam dużo odbiorników IR, to sprzężyłem taki jeden z robotem, spisałem kody z pilota do ledów i zrobiłem mapowanie przycisków. Następnie wziąłem się za lutowanie płytki pod niego. Kilka godzin lutowania, plątanina kabli z drugiej strony, ale działa. (mistrz painta w akcji): Płytka w procesie projektowania, a bardziej patrzenia czy wszystko jest ok Tutaj podczas wgrywania programu, stabilizator ze starego monitora okazał się być zużyty Gotowa płytka: Na płytce za zasilanie odpowiada stabilizator 7805 (oczywiście z radiatorem i kapką pasty termoprzewodzącej), z kondensatorem 100uF. W środku stara dobra atmega 328, z kwarcem 16Mhz i brzęczykiem z diodą led. Najwięcej jest wyprowadzeń, bo cała listwa 4x3 dla serw, złącze od HC-SR04, VS1838B, interfejsu UART a nawet złącze programatora. Cała płytka ma 60x30mm. Źródło napięcia to 2 akusy lipo na 7.4V (tylko takie miałem) o pojemności 1800mAh. Wyjęte z tableta - tam dużo fajnych rzeczy można znaleźć... Początkowo miałem dać 2 akusy 18650, ale one były za duże pod moją płytkę. Jedno 18650 ze step upem to samo. Więc zostały liposy, które niestety nie są zbyt ciężkie i robot ma dość nisko środek ciężkości (powinien być "na środku", pierwotnie tam miały siedzieć 4 paluszki aa) Zostało napisać kod. Skorzystałem z gotowych bibliotek pod otto, gdzie miałem gotowe sterowanie serwami i czujnikiem. Był za to ogromny kłopot z bibliotekami, bo te gryzły się z timerami których używała biblioteka od otto. Na chińskim githubie znalazłem jakimś cudem bibliotekę od IR która nie używa timerów, biblioteka od dźwięków była łatwiejsza do znalezienia ale musiałem wykonywać modyfikacje w niej, tak czy siak. Sam kod nie jest skomplikowany, po funkcjach startujących peryferia co chwilę sprawdzamy czy odebraliśmy jakiś kod z pilota - jeżeli tak, wykonujemy funkcję z nim związaną. W przeciwnym wypadku wykonujemy kod danego trybu, a jest ich 3: (wiem, na zdjęciu jest ich więcej ale uznałem że są niepotrzebne dla mnie): tryb swobodny, czyli nie robimy nic, tryb omijania przeszkód, tutaj za dużo tłumaczyć nie trzeba, tryb śledzenia: po wykryciu dłoni, robot idzie w jej kierunku. A oto cały kodzik, może kiedyś go dam na githuba bo szkoda by się u mnie marnował: //---------------------------------------------------------------- //-- Otto IR mod //-- Does many things, controlled by an IR remote. //-- (insert github here) //-- CC BY SA (http://ottodiy.com) //-- 02 June 2019 by Leoneq ;3 //----------------------------------------------------------------- // INCLUDES --------------------------- #include <Servo.h> //servo library #include <Oscillator.h> //important library #include <US.h> //ultrasonic library #include <Otto.h> //otto library #include <motoIRremote.h> //timer-free ir library #include <TimerFreeTone.h> //timer-free tone library // PINS ------------------------------- #define PIN_LEFT_HIP 2 #define PIN_RIGHT_HIP 3 #define PIN_LEFT_ANKLE 5 #define PIN_RIGHT_ANKLE 4 #define PIN_IR 6 #define PIN_LED 13 // TRIMS ------------------------------ #define TRIM_LEFT_HIP -9 #define TRIM_RIGHT_HIP -9 #define TRIM_LEFT_ANKLE 0 #define TRIM_RIGHT_ANKLE -20 // OBJECTS ---------------------------- Otto Otto; //This is Otto! IRrecv ir(PIN_IR); decode_results IR_RES; // VARIABLES -------------------------- int WALK_TIME = 1000; int WALK_DIR = 1; int WALK_HEIGHT = 20; int speed = 3; int US_DIST = 0; bool obstacleDetected = false; String IR_CODE = ""; String IR_SYMBOL = ""; #define UP "f700ff" #define DOWN "f7807f" #define OFF "f740bf" #define ON "f7c03f" #define ONE "f720df" #define TWO "f7a05f" #define THREE "f7609f" #define FOUR "f710ef" #define FIVE "f7906f" #define SIX "f750af" #define SEVEN "f730cf" #define EIGHT "f7b04f" #define NINE "f7708f" #define TEN "f708f7" #define ELEVEN "f78877" #define TWELVE "f748b7" #define THIRTEEN "f728d7" #define FOURTEEN "f7a857" #define FIFTEEN "f76897" #define W "f7e01f" #define FLASH "f7d02f" #define STROBE "f7f00f" #define FADE "f7c837" #define SMOOTH "f7e817" /* * There are 5 modes attached to: * W - avoid obstacles (1) * FADE - follow hand! (2) * SMOOTH - free mode. Do anything what you want! (3) */ byte OTTO_MODE = 5; void setup() { Serial.begin(115200); //enable serial for debugging ir.enableIRIn(); //enable ir sensor Otto.init(PIN_LEFT_HIP,PIN_RIGHT_HIP,PIN_LEFT_ANKLE,PIN_RIGHT_ANKLE,true); //init otto! Otto.setTrims(TRIM_LEFT_HIP,TRIM_RIGHT_HIP, TRIM_LEFT_ANKLE, TRIM_RIGHT_ANKLE); //set trims //why not in one line? here, in code it looks better. Serial.println("Otto IR Mod by Leoneq :3"); Serial.println("Summer 2019"); Serial.println("-----------------------------------"); Serial.println("Ready."); Otto.sing(S_connection); //let us know, that otto woke up! Otto.home(); //set initial position delay(100); Otto.sing(S_happy); //when you are happy, otto should be too ;) //end of setup function } void checkIR() { if (ir.decode(&IR_RES)) //if we get something { IR_CODE = String(IR_RES.value, HEX); //we save received data into string Serial.print("Received data: 0x"); Serial.println(IR_CODE); //lets write it on serial checkIRcode(); //we must know what button is pressed delay(250); //little delay ir.resume(); } } void loop() { checkIR(); //check for new ir signals switch(OTTO_MODE) { case 1: //avoid obstacles avoid(); break; case 2: //follow hand mode follow(); break; case 3: //free mode free(); break; } } void free() { //nothing! } void follow() { obstacleDetected = obstacleDetector(); if(obstacleDetected) { Otto.walk(1,1000,FORWARD); } else { Otto.home(); } } void dance() { //soon } void sing() { //soon } void avoid() { obstacleDetected = obstacleDetector(); if(obstacleDetected) { Otto.sing(S_surprise); Otto.walk(5,1000,BACKWARD); delay(1000); Otto.sing(S_happy); Otto.turn(3,1000,RIGHT); delay(2000); } else { Otto.walk(1,1000,FORWARD); } //end of avoid() function } bool obstacleDetector() { int distance = Otto.getDistance(); Serial.print("Distance: "); Serial.println(distance); if(distance<15) { return true; } else { return false; } } void up() { IR_SYMBOL = "UP"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); speed--; Serial.print("Changing speed! The new speed is: "); Serial.print(speed); } void down() { IR_SYMBOL = "DOWN"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); speed++; Serial.print("Changing speed! The new speed is: "); Serial.print(speed); } void off() { IR_SYMBOL = "OFF"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.print("See you later!"); Otto.home(); Otto.playGesture(OttoSleeping); Otto.sing(S_sleeping); } void on() { IR_SYMBOL = "ON"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Turning on..."); Otto.sing(S_happy); Otto.playGesture(OttoHappy); Otto.home(); } void _one() { IR_SYMBOL = "1"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Moonwalking!"); Otto.sing(S_superHappy); Otto.moonwalker(3,speed*300,30,1); Otto.home(); } void _two() { IR_SYMBOL = "2"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("jump!"); Otto.jump(3, speed*300); } void _three() { IR_SYMBOL = "3"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Am I taller?"); Otto.updown(1, speed*300, 22); } void _four() { IR_SYMBOL = "4"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("I'm happy, because you are with me!"); Otto.sing(S_happy); Otto.playGesture(OttoLove); } void _five() { IR_SYMBOL = "5"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("I'm so sad, help me :("); Otto.sing(S_confused); Otto.playGesture(OttoSad); Otto.sing(S_sad); } void _six() { IR_SYMBOL = "6"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("mmmphm!"); Otto.sing(S_fart1); Otto.playGesture(OttoFart); Otto.sing(S_fart3); Otto.playGesture(OttoWave); } void _eight() { IR_SYMBOL = "8"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Going forward!"); Otto.walk(3, speed*300, 1); Otto.home(); } void _fourteen() { IR_SYMBOL = "14"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Going backwards!"); Otto.walk(3, speed*300, -1); Otto.home(); } void _ten() { IR_SYMBOL = "10"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Rotating left, please wait..."); Otto.turn(3, speed*300, 1); Otto.home(); } void _twelve() { IR_SYMBOL = "12"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Rotating right, please wait..."); Otto.turn(3, speed*300, -1); Otto.home(); } void _eleven() { IR_SYMBOL = "11"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("I am standing up!"); Otto.home(); } void _w() { IR_SYMBOL = "W"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Obstacle avoid mode: ACTIVATED"); OTTO_MODE = 1; } void _flash() { IR_SYMBOL = "FLASH"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Follow mode: ACTIVATED"); OTTO_MODE = 2; } void _strobe() { IR_SYMBOL = "STROBE"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Free mode: ACTIVATED"); OTTO_MODE = 3; } void _seven() { IR_SYMBOL = "7"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Standing one foot!"); Otto.bend(1, 2000, 1); } void _nine() { IR_SYMBOL = "7"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); Serial.println("Standing one foot!"); Otto.bend(1, 2000, -1); } void checkIRcode() { if(IR_CODE == UP) up(); else if(IR_CODE == DOWN) down(); else if(IR_CODE == OFF) off(); else if(IR_CODE == ON) on(); else if(IR_CODE == ONE) _one(); else if(IR_CODE == TWO) _two(); else if(IR_CODE == THREE) _three(); else if(IR_CODE == FOUR) _four(); else if(IR_CODE == FIVE) _five(); else if(IR_CODE == SIX) _six(); else if(IR_CODE == SEVEN) _seven(); else if(IR_CODE == EIGHT) _eight(); else if(IR_CODE == NINE) _nine(); else if(IR_CODE == TEN) _ten(); else if(IR_CODE == ELEVEN) _eleven(); else if(IR_CODE == TWELVE) _twelve(); else if(IR_CODE == THIRTEEN) IR_SYMBOL = "13"; else if(IR_CODE == FOURTEEN) _fourteen(); else if(IR_CODE == FIFTEEN) IR_SYMBOL = "15"; else if(IR_CODE == W) _w(); else if(IR_CODE == FLASH) _flash(); else if(IR_CODE == STROBE) _strobe(); //else if(IR_CODE == FADE) _fade(); //else if(IR_CODE == SMOOTH) _fade(); //we cant do switch case with string else IR_SYMBOL = "UNKNOWN"; Serial.print("The symbol is: "); //lets write symbol on serial Serial.println(IR_SYMBOL); } Efekty prac są podane na zdjęciach. Film dorzuce później, jak na yt wrzucę. Robot został nazwany pubga, na pamięć mojego kolegi z 8. klasy, który co chwile mówił do nauczycieli "a pogramy w pubga? pubga, w pubga!" przez chyba cały czerwiec XD W przyszłości chyba nie będę miał na niego za dużo czasu, bo technikum itd. Może na jakiś długi weekend, zamontuję do niego esp, jakieś dodatkowe czujniki albo miotacz ognia. Kto wie. Miłych wakacji, Leoneq ;3 -

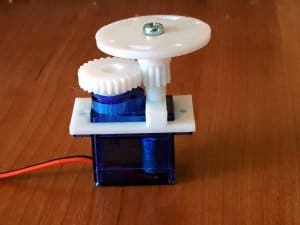

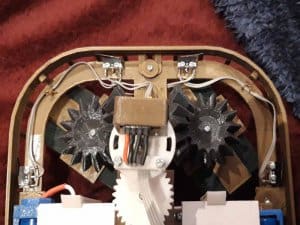

No cóż - trochę mi to czasu zajęło. Ale dziś mam zaszczyt przedstawić Księżniczkę i Krasnoluda. Z czystym sumieniem umieszczam to w dziale "roboty" - tym razem lalki mają przynajmniej częściową autonomię czyli jak najbardziej zasługują na miano robota. Ale może chronologicznie. W pewnym momencie stwierdziłem, że teatralne lalki (klasyczne czy z dodatkiem elektroniki) to trochę za mało, i postanowiłem zrobić jakąś postać w pełni zdalnie sterowaną i z możliwością wykonania jakiegoś mniej lub bardziej skomplikowanego programu. Wybrałem Piękną Księżniczkę i zacząłem robić założenia. Wyszło mi coś takiego: Konstrukcja głowy podobna jak w poprzednich lalkach (wypróbowana, sprawdzona). Jedno serwo do napędu oczu, dwa do pochylenia i obrotu głowy. Zrezygnowałem z pełnego ruchu głowy (tak jak w mlle Woni) ze względu na trudności zarówno w animacji, jak i wykonaniu mechanizmu w domowych warunkach, a efekt nie jest wart zachodu. Silniki krokowe do napędu Zasilanie z dwóch akumulatorów 18650. Implikowało to zastosowanie stepperów EasyDrive (napięcie zasilania) i niewielkich silników NEMA14 ESP32 jako procesor Bezprzewodowy pad (z Botlandu) do sterowania. Na początek poszło podwozie. Teoretycznie wszystko było jak trzeba: dwa koła napędowe osadzone w osi lalki po bokach i dwie kulki podporowe (z przodu i z tyłu). Taki układ powinien zapewnić stabilność... Jako że po zmontowaniu podwozie jeździło całkiem zacnie, zabrałem się za resztę. I tu pierwsza trudność: serwa HD-1370A teoretycznie powinny mieć na tyle duży moment, aby podnieść lekką rękę lalki. Nie wziąłem jednak pod uwagę bezwładności - próby skończyły się rozwaleniem zębatek w serwie i zastosowaniem trochę porządniejszych (z metalowymi trybami). Dalej było tylko gorzej. Szybkie podniesienie ręki kończyło się wpadnięciem serwa w oscylacje. Jako-tako opanowałem to, zmniejszając maksymalną dopuszczalną prędkość ruchu serwa. Kontroler (pad) okazał się absolutną pomyłką. Nie ma mowy o żadnej precyzji, w końcu użyłem go e trybie cyfrowym (czyli jak joysticka w C64). W związku z tym musiałem jakoś uprościć sterowanie; zrezygnowałem z bezpośredniego sterowania oczami, głowa wykonuje tylko podstawowe gesty (tak/nie oraz spojrzenia w ośmiu kierunkach). Do regulacji prędkości silników napędowych użyłem przycisków R1/R2 - nie jest to idealne rozwiązanie, ale pozwalające na względnie dokładną kontrolę ruchu lalki. No i to nieszczęsne podwozie - pomysł był dobry, ale wykonanie absolutnie do niczego. Nie wiem co mi się przyśniło żeby silniki napędowe umocować na sztywno do korpusu a resorowanie dać na kulkach podporowych; w rezultacie lalka kołysze się w trakcie ruszania, zatrzymywania czy zmiany prędkości. Na szczęście byłem zadowolony przynajmniej z głowy. A jako, że lalka może wykonywać różne, nawet dość długie sekwencje ruchów - efekt był całkiem niezły. Przy okazji okazało się, że dodatkowy sterownik (w założeniu miał służyć wyłącznie do wyzwalania kolejnych sekwencji) co prawda działa bardzo dobrze, ale jest absolutnie bezużyteczny, więc nawet nie dokończyłem fragmentu programu obsługi. Zresztą - program w tej postaci jaka jest nadaje się tylko do napisania od zera. Tak więc Księżniczka dostała sukienkę, perukę, rzęsy i makijaż i stanęła sobie na półce aby ładnie wyglądać. Na pewno zabiorę się za przeróbkę zarówno mechanizmu, jak i programu (poczynając od wywalenia w diabły tego nieszczęsnego pada), ale to raczej zadanie na przyszłość. Teraz postanowiłem podejść do sprawy nieco inaczej. Przede wszystkim - chciałem spróbować RPi Pico jako głównego kontrolera. Do tego chciałem podłączyć RPi Zero 2 W, do programowania Pico i do obsługi kamery (jednym z zadań lalki było patrzenie w twarz rozmówcy). Poza tym musiałem przemyśleć sprawę podwozia. Zastosowałem co prawda identyczne silniki i sterowniki jak w Księżniczce, ale tym razem całość zasilana jest z akumulatora Parkside V20 2Ah. Postanowiłem rozwiązać sprawę podwozia nieco inaczej. Teraz to kulki podporowe były połączone na stałe z korpusem, a silniki umieściłem na wahaczu. Dwie sprężyny dbają o prawidłowy kontakt kół z podłożem nawet przy jeździe po nierównej podłodze. I taka konstrukcja jeździ już prawie dobrze (dlaczego prawie - o tym na zakończenie). Ręce rozwiązałem w nieco inny sposób. Oprócz uniesienia ręki lalka ma możliwość skręcenia dłoni (dłoń jest przymocowana do osi, którą obraca małe serwo w przedramieniu), a otwieranie i zamykanie palców wziąłem z mlle Woni. Całość wygląda w ten sposób: Trochę inaczej rozwiązałem głowę. Tym razem zrezygnowałem z naturalistycznego wyglądu. Ponieważ pierwotnie miał być to Troll a nie Krasnolud - naturalne wydało mi się wydrukowanie twarzy i dłoni z szarego filamentu (w końcu trolle mają coś wspólnego ze skałami, a te są najczęściej szare). Trudności techniczne zmusiły mnie do zmiany podejścia (w porę stwierdziłem, że nie mam szans na prawidłowe odwzorowanie postaci trolla bez jakichś cilikonowych odlewów, na których się absolutnie nie znam), ale w końcu Krasnoludów jest wiele gatunków, a mój jest właśnie jaskiniowy i trudni się kamieniarstwem 🙂 Wracając do głowy: spróbowałem inaczej rozwiązać kwestię skłonu (przekładnia zębata). Dodatkowo zrezygnowałem z ruchu oczu na boki; w to miejsce wprowadziłem ruch pionowy (tak jak w "zamykających oczy" lalkach). Co prawda pozwala to na dodatkowy efekt (włączenie odpowiedniej funkcji powoduje, że Krasnolud może sobie mrugać w losowych odstępach czasu), ale ogólnie ruch oczu na bioki daje więcej możliwości animacyjnych. Ideałem byłoby umożliwienie ruchu zarówno w poziomie jak i w pione - ale to zarezerwowałem sobie do następnej konstrukcji. Pionowy ruch oczu zrealizowałem nietypowo - za pomocą paska zębatego. Zdjęcie jest trochę niewyraźne, ale wnętrze głowy wygląda w ten sposób: Niestety - musiałem z przyczyn absolutnie ode mnie niezależnych zrezygnować z kamery. Po prostu okazało się, że Zero 2 W jest absolutnie niedostępny, a zwykły Zero W nie jest w stanie w jakimś sensownym czasie znaleźć twarzy na obrazie z kamery. Próbowałem zrobić po prostu streaming - uznałem jednak, że to mało przydatna funkcja, a pracujący serwer bardzo skutecznie zagłuszał sygnał radiowy sterowania. W związku z tym wyrzuciłem kamerę, w jej miejsce włożyłem czujnik ToF i postanowiłem, że zrobię przy okazji program "spacer" (czyli typowe unikanie przeszkód). Więcej czasu poświęciłem sterownikowi. Co prawda wygląda on nieco prowizorycznie, ale bardzo dobrze spełnia swoja funkcję. Użyłem tym razem precyzyjnych joysticków (dzięki kol. @Sabre). Dzięki temu mogę bardzo precyzyjnie sterować ruchami robota - zarówno napędami, jak i głową. Niestety, znów natrafiłem na problem wpadanie ręki w oscylacje. Wydawało mi się, że zastosowanie mocnego serwa (użyte przeze mnie ma 5 kG*cm) poskutkuje wymuszeniem prawidłowego ruchu ręki. Niestety - nic z tego; przy szybszych ruchach ręce znów wpadały w oscylacje. I znów poradziłem sobie z tym problemem naokoło - spowalniając ruch serwa. Jak widać na filmie - w przeciwieństwie do Księżniczki ręce Krasnoluda poruszają się z większą precyzją. Zresztą kod sterownika zamieszczam tutaj - może nikt nie będzie chciał budować takiego samego, ale część rozwiązań może się przydać (działająca biblioteka nRF24 chociażby). geopilot.zip W międzyczasie (już gdy miałem całą konstrukcję mniej więcej złożoną) pojawił się całkiem używalny polski głos dla syntezatora RHVoice. Z bólem serca pożegnałem więc Milenę i Kedrigerna. Co prawda syntezator jest strasznie mulasty (samo wczytanie np. ukraińskiego głosu zajmuje mojemu Zero W kilkanaście sekund), ale kolejne kwestie wypowiadane są już z prawie niezauważalnym opóźnieniem. Dodatkowo mogłem wprowadzić drugi język (ukraiński - ważne, bo Krasnolud lubi czasem zawitać do przedszkola do którego uczęszczają również dzieci z Ukrainy). A tak wyglądają Księżniczka i Krasnolud w realu: Niestety - z przyczyn prawnych nie mogę zamieścić nagrań z przedszkola, ale sam byłem zdziwiony jak dzieci szybko orientują się w obsłudze dość skomplikowanego w sumie kontrolera. Przy okazji "spaceru"... okazało się, że wysoko umieszczony czujnik (tam, gdzie miała być kamera - czyli w kasku) nie łapie przeszkód znajdujących się blisko podłogi. Poradziłem sobie z tym zupełnie inaczej. Ponieważ robot w czasie spaceru porusza się symulując chód (uruchamiane są silniki naprzemiennie, a głowa i ręce kontrują obrót tułowia), całość jest synchronizowana żyroskopem (po osiągnięciu 8 stopni odchylenia od kierunku następuje przełączenie silników i obrót w drugą stronę) wystarczyło sprawdzić, czy robot rzeczywiście się obraca; jeśli tak - oznacza to napotkanie przeszkody której nie wykrył czujnik ToF. I jeszcze o popełnionych błędach i niedociągnięciach... Nie mówię tu o błędach w programie (w ostatniej chwili okazało się, że jest tam dość krytyczny błąd, nie mam dzisiaj już czasu sprawdzać ale robot musi być gotowy do spotkania z dziećmi od początku września). Z tego też powodu na razie nie zamieszczam kodu samego robota. Kulki podporowe są fajne, ale dla dość ciężkiego i robota poruszającego się po niespecjalnie równym podłożu nawet calowe kulki są za małe, aby robot potrafił np. wjechać na dywan. Na razie nie mam pomysłu na rozwiązanie tego problemu, ale liczę na Wasze podpowiedzi. Wydrukowane opony mają za małą przyczepność, i koła wpadają czasem w poślizg. Można to zobaczyć na filmie, kiedy robot w czasie spaceru próbuje cofnąć się od nieistniejącej przeszkody. Tu muszę poeksperymentować z oponami; w Księżniczce użyłem oryginalnych silikonowych opon zdjętych z tanich kół. Niestety - tu koła mają nieco większą średnicę. Będę musiał po prostu wypróbować kilka możliwości - na razie myślę o wydrukowaniu węższych kół i zrobieniu opon bez bieżnika z TPE zamiast TPU. Jeśli o czymś zapomniałem - jestem do dyspozycji 🙂

-

Freestyle Robot gąsienicowy PENETRATOR

Arturo opublikował temat w Projekty - DIY w budowie (worklogi)

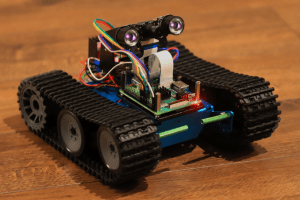

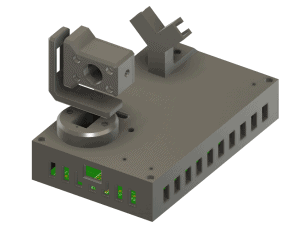

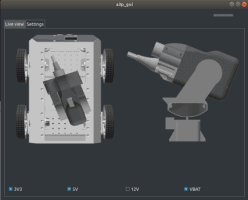

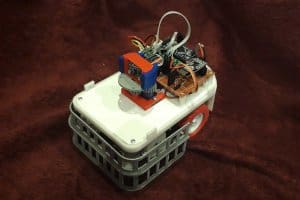

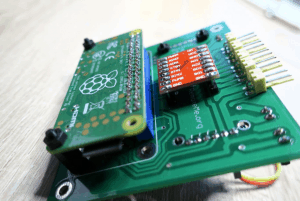

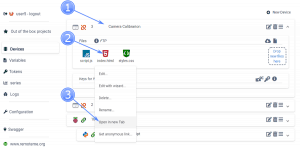

Cześć. Chciałem wam pokazać projekt nad którym pracuję: PENETRATOR Trochę konkretów: aluminiowy kadłub napęd: dwa silniki elektryczne szczotkowe 9V zasilanie 2 x 18650 + 2 x 18650 ukryte pod kadłubem kontroler: Raspberry Pi 3 A+ wizja: moduł kamery 1080p emitery IR umożliwiające kamerze pracę w ciemnościach łączność: WiFi (access point i serwer HTTP) język programowania : Python 3 sterowanie i obraz: autorska aplikacja webowa (w przeglądarce) umożliwiająca wyświetlanie obrazu z kamery i sterowanie robotem W PLANACH: mechaniczne ramię 7DOF oparte na serwomechanizmach MG996R obracanie kamery w 2 płaszczyznach przy pomocy serwomechanizmów mam też ochotę pobawić się sztuczną inteligencją, stąd wybór raspberry a nie np. esp8266 Przy okazji, podziękowania dla Forbot.pl za podstawy które wprowadziły mnie do świata robotyki- 10 odpowiedzi

-

- 7

-

-

- gąsienicowy

- robot

-

(i 2 więcej)

Tagi:

-

Ech, miało być dużo wcześniej... Niestety okazało się, że co prawda pandemia zmusiła mnie (a właściwie nas, bo moją kochaną też) do siedzenia w domu, ale dodała mi (nam) tyle roboty, że nie bardzo miałem czas na ukończenie projektu. W każdym razie mam zaszczyt wreszcie przedstawić dyplomowaną wiedźmę, pannę (z gatunku tych starszych) Wolhę Nikołajewnę Androinę (dla znajomych Wonia, dla dalszych znajomych mlle Wonia). I od razu wyjaśnienie: tak, mimo wyglądu jest to skończony projekt. Podobnie jak Maestro Zitaurus, Wonia to konstrukcja lalki. Wszelkie włosy, ubrania to zupełnie inna historia: po pierwsze lalkę można ubrać i ucharakteryzować różnie; raz może być złą czarownicą - innym razem dobrą babcią... po drugie pracownie krawieckie są na razie niedostępne i nic nie zapowiada, aby w najbliższej przyszłości coś się zmieniło. Ale zacznę od początku. Wspomniany już Ziutek co prawda sprawdził się na scenie, ale kilka "drobiazgów" znakomicie utrudniało animację. Mechaniczny (bezpośredni) napęd głowy nie pozwolił na wygodne umieszczenie joysticka, a umieszczenie przycisku sterowania dłonią na rękojeści czempuritu bardzo skutecznie uniemożliwiło animację obu rąk jednocześnie. Konstrukcja dłoni też pozostawiała wiele do życzenia - umieszczenie serwomechanizmu w przedramieniu co prawda pozwoliło na zastosowanie typowego SG90, ale przeniesienie napędu na palce było zbyt skomplikowane. Postanowiłem więc skonstruować następną jawajkę - tym razem pozbawioną tych wad. Na pierwszy ogień poszła konstrukcja dłoni. Kiedyś kupiłem na próbę subminiaturowe serwa PowerHD 1370A - okazało się, że świetnie nadają się do tego typu konstrukcji. Są ciche, pobierają niewiele prądu, a rachityczny moment nie przeszkadza przy pracy praktycznie bez obciążenia (dłonie i oczy). Poza tym niewielkie wymiary pozwoliły na umieszczenie serwa bezpośrednio w dłoni i osadzenie palców bezpośrednio na orczyku serwa. Większy problem miałem z opracowaniem napędu głowy. Tym razem postanowiłem, że napęd będzie całkowicie elektryczny i sterowany wyłącznie joystickiem. Dodatkowo chciałem spróbować typowej dla animatroniki konstrukcji umożliwiającej przechyły głowy nie tylko w przód, ale również na boki. Niestety - narzucające się rozwiązanie z przegubami kulowymi (takimi jak stosowanie w drążkach kierowniczych pojazdów RC) było niemożliwe do zrealizowania; dostępne w handlu były po prostu za duże, a samodzielne ich wykonanie w domowych warunkach nie wchodziło w grę. Zrobiłem kilka prób, ale okazało się, że w wykonanych na drukarce przegubach luzy są zbyt duże, aby umożliwić jakikolwiek sensowny ruch - szczególnie w lalce, która wierci się i skacze na wszystkie strony. Już miałem zrezygnować z przechyłów na boki i zastosować sprawdzony sposób z przechyłem tylko w przód... ale w międzyczasie kupiłem zupełnie w innym celu komplet różnych sprężynek. Spróbowałem więc rozwiązania, gdzie sprężyna ściąga głowę do neutralnego położenia, a serwomechanizmy pracują jedynie w trybie pociągania za drążek. I to mnie uratowało - luzy są skutecznie kasowane przez sprężynę, a za napęd mogły posłużyć takie same serwa, jak w dłoniach. Obrót głowy zrealizowałem za pomocą jeszcze jednego takiego samego serwa przekładni zębatej. Jako że podstawowe sprawy z mechaniki miałem już rozwiązane, przyszła kolej na elektronikę. Tym razem lalka powinna działać w dwóch trybach: pierwszy to bezpośrednie sterowanie za pomocą joysticka i przełączników na rękojeści lalki, drugi to typowy w konstrukcjach Hensona sposób animacji przez dwie osoby: pierwsza robi to bezpośrednio w typowy dla jawajki sposób, druga (pomocnik) zdalnie steruje głową i zamykaniem dłoni. Jako głowny kontroler posłużył mi Arduino Pro Mini sterujący bezpośrednio serwami, do komunikacji ze zdalnym manipulatorem użyłem modułów nRF24L01+. Rękojeść jest tym razem pionowa, wewnątrz ukryte są Arduino, transceiver i przetwornica zasilająca elektronikę. Również w rękojeści znajduje się joystick sterujący głową, klawisze dłoni oraz przełącznik sterowania oczami. Klawisze dłoni mają różną wysokość ułatwiającą oddzielne manipulowanie dłońmi jednym palcem, przełącznik oczu został umieszczony tak, aby małym palcem można było bez problemu skierować wzrok lalki w odpowiednią stronę. Rękojeść jest dopasowana do konkretnej osoby - stąd widoczne na filmie trudności w animacji (film nagrywałem sam, a rozstaw joysticka i przycisków po prostu nie pasuje do mojej dłoni). Ponieważ musiałem zrealizować sterowanie trzema serwami za pomocą pojedynczego dwuwymiarowego joysticka, musiałem użyć pewnego tricku. Przesunięcie joysticka w dół powoduje skłon główy do przodu, przesunięcie na boki obrót, przy czym pochylenie głowy na bok realizowane jest przez jednoczesne przesunięcie joysticka w bok i w dół. Co prawda przy takim sterowaniu nie jest możliwe pochylenie głowy na bok bez obrócenia jej, ale taki taki efekt można uzyskać poprzez zaangażowanie drugiego animatora-pomocnika (zdalne sterowanie pozwala na dowolne ustawienie głowy). I tu ciekawostka. Któryś z kolei raz składając rękojeść omyłkowo przekręciłem joystick o 90°. I to był strzał w dziesiątkę: przy takim układzie można osiągnąć dużo większą precyzję w sterowaniu głową. Kontrola ruchu kciuka w linii prostopadłej do palców (a więc równoległej do osi rękojeści) jest dokładniejsza, a ta dokładność jest potrzebna przede wszystkim przy obrocie głowy. No i oczywiście musiałem popełnić jeden błąd - zasilanie. Początkowo zakładałem akumulator LiPo 2000 mAh i moduł przetwornicy MT3608. Wszystko pięknie działało dopóki nie poskładałem tego do kupy... okazało się, że zestaw akumulator-przetwornica nie wyrabia się szczególnie przy starcie urządzenia. Co prawda układ bardzo ładbnie startował przy odłączonych serwach, ich podłączenie już po starcie umożliwiało dalszą pracę ale i tak Arduino działał niestabilnie, a przy uruchomieniu wszystkich serw układ potrafił się zresetować. Wybrałem więc rozwiązanie najprostsze: zastosowałem dwie przetwornice (oddzielna na elektronikę, oddzielna na serwa) i największy akumulator LiPo z oferty Botlandu. Ustawienie drugiej przetwornicy na 6V pomogło przy okazji serwomechanizmom. Na załączonych zdjęciach widoczne są obie przetwornice - jedna w rękojeści do zasilania elektroniki, druga z tyłu lalki pod akumulatorem (do serw). Teraz przyszła kolej na sterownik dla pomocnika. W teorii urządzenie jest proste - Arduino, transceiver (tu użyłem wersji z anteną) kilka klawiszy, joystick... no i właśnie na joysticku się zaciąłem. Próbowałem różnych mocowań potencjometrów, ale urządzenie wychodziło mi jakieś wielkie i nieporęczne, poza tym operowanie czymś takim było piekielnie niewygodne. Chciałem sobie uprościć robotę, kupić zwykły joystick analogowy od peceta i na nim zamontować trzeci potencjometr - niestety, nie mogłem trafić na żadną sensowną ofertę w sieci. W końcu gdzieś na Thingiverse znalazłem szkic podobnej konstrukcji, no i po paru godzinach spędzonych nad OpenSCAD-em miałem gotowy projekt: Ostatecznie całość wygląda tak jak poniżej na zdjęciu. A, i jak zwykle jakiś błąd musiałem popełnić. Skorzystałem tu z gotowej obudowy Kradexu, wymierzyłem, znalazłem akumulator który się tam mieści i... zamawiając go w Botlandzie kliknąłem na sąsiedni link. Stąd takie dziwne umieszczenie akumulatora na zewnątrz - po prostu ten model nie zmieścił się w obudowie 🙂 I tyle miałem przed pandemią. Co więc tak opóźniło opublikowanie projektu? Otóż zarówno w lalce, jak i w sterowniku zrezygnowałem z wbudowania ładowarki. Ponieważ oba akumulatory mają identyczne złącza JST, postanowiłem zrobić uniwersalną ładowarkę z możliwością przełączania prądu ładowania. Ustrojstwo niesamowicie proste: w zwykłym module TP4056 usunąłem rezystor 1.2k i w miejsce tego podłączyłem drabinkę z kilku rezystorów oraz przełącznik obrotowy, a do wyjścia podłączyłem gniazdo JST. Niestety, przed pandemią nie zdążyłem zmontować ładowarki, a nie mogłem przecież opisać niekompletnego urządzenia! Jeśli kogoś to interesuje, zamieszczam kody lalki i sterownika: lalka.zip O ile kod lalki jest dość typowy, to w kodzie sterownika zastosowałem pewien trick którego nie widziałem na razie w żadnych konstrukcjach - diodę sygnalizującą połączenie radiowe z lalką. Może się komuś przyda... Schematów nie zamieszczam, bo w rzeczywistości oba urządzenia (sterownik i lalka) to płytka Arduino z podłączonymi do odpowiednich pinów transceiverem, przyciskami, diodami i tak dalej, a cała pinologia jest zamieszczona w źródłach. Na koniec wyjaśnienie - skąd akurat takie imię? Miłośnicy fantasy pewnie już wiedzą o kogo chodzi, ale na wszelki wypadek podaję link do książki 🙂

-

KTR-X1 8x8 To pojazd zdalnie sterowany do wykonywania zadań w bardzo trudnym terenie, charakteryzuje się prostotą konstrukcji, niskim środkiem ciężkości oraz uniwersalnością. KTR-X1 8x8 zbudowany jest z dwóch sekcji połączonych przegubem, dzięki temu każda sekcja jest niezależna, dodatkowo ruchome wahacze dają ogromne możliwości w pokonywaniu przeszkód w terenie. Pojazd obojętnie w jakim terenie się porusza,oraz jak stoi, zawsze ma doskonałą przyczepność na wszystkie 8 kół. Dzięki temu że KTR-X1 jest hybrydą można bez obaw wybrać się na dalekie wyprawy gdyż prądu nam nie zabraknie. Specyfikacja: Podwozie: rama stalowa z profila zamkniętego 30x30x1,5 spawana Wahacze: profil zamknięty 40x80x2 wspawane bloki łożyskowe Osie: stal utwardzana Poszycie: blacha aluminiowa 0.8mm wzmacniania kątownikami Przegub: blacha stalowa 10mm plus łożyska Przeniesienie napędu: przekładna łańcuchowa przełożenie1,5:1 Napęd: 4 silniki 24V / 450W każdy (moc znamionowa) 123 RPM Układ skrętu: pompa hydrauliczna 120 bar plus dwa siłowniki Sterownik silnika: Sabertooth 4x32A Sterownik pompy: Sabertooth 2x32A Zasilanie: Akumulatory kwasowe 12V 40Ah 2x Układ ładowania: silnik spalinowy 200c OHV plus alternator 28V 55A Koła: 145/70/6 Pilot sterowania: HK-T6 Oświetlenie: led 2x9W przód, 2x2W tył Układ chłodzenia: 2x wentylator 4800 RPM Przyłącza: szybkozłącze montażowe plus gniazdo zasilania Spalanie: 0,5-1,2l/mth Masa: 140Kg Prędkość max: 8km/h Wymiary: szer 90cm, dłu 192cm, wys 68cm, prześwit 27cm Dalsze plany: Pług do śniegu obrotowy (zrobiony) Zamiatarka (dalszy etap) Kosiarka (dalszy etap)

-

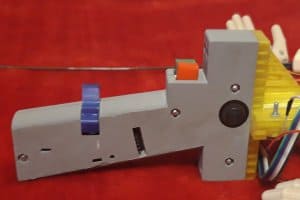

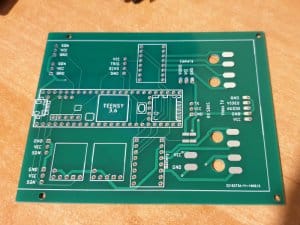

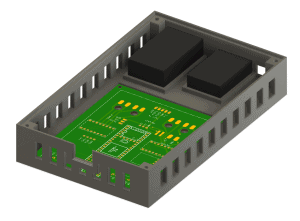

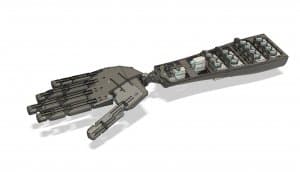

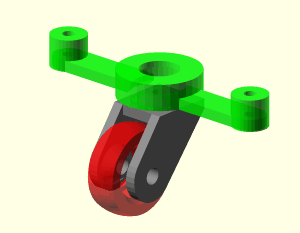

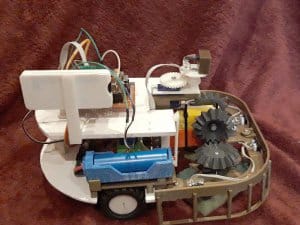

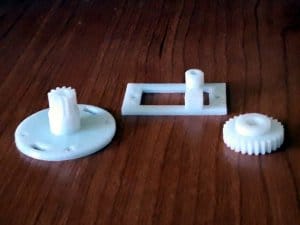

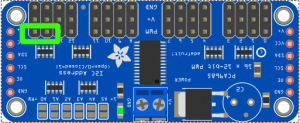

Jakiś czas temu opisałem budowę pojazdu zdalnie sterowanego. Przypomnę, efekt końcowy wyglądał mniej więcej następująco: Już w poprzednim poście wypunktowałem wszystkie wady powyższego projektu - zaczynając od sterczących wszędzie kabli, anten mocowanych na taśmę izolacyjną, ogromnego Leonardo z shieldem sterującym silnikami w charakterze kontrolera, a wszystko na DIY płytce aluminiowej: działać działało, ale wyglądało... no, nazwijmy rzecz po imieniu, tragicznie. Postanowiłem więc zabrać się za temat trochę bardziej poważnie - a że w międzyczasie wyposażyłem się w drukarkę 3D, miałem spore pole do popisu. Zmienił się też charakter projektu. Zamiast czujnika zbliżeniowego zdecydowałem się zamontować kamerkę z przekaźnikiem wideo - ze zdalnie sterowanego pojazdu powstał więc w mały robot inspekcyjny. Na pierwszy ogień poszły komponenty. Leonardo wyleciało do innego projektu, gdzie miało o wiele więcej sensu, a w jego miejsce trafił Teensy 3.6 (pod linkiem 3.5 dostępny w Botlandzie - różnią się głównie mocą obliczeniową). Shield zastąpiłem dwoma osobnymi dwukanałowymi sterownikami silników DRV8833. Zasilanie szło z dwucelowego akumulatora LiPo, więc konieczny był też zakup przetwornic step-down, ale nauczony doświadczeniem kupiłem dwie: jedna zasilała Teensy i odbiornik RC, zaś druga - dwa mikro serwa, które sterowały położeniem kamerki. Sterowniki silników dostały napięcie bezpośrednio z akumulatora, bo obsługiwały je bezpośrednio, podobnie nadajnik video. Drugim krokiem było zaprojektowanie płytki. Miałem już dosyć sterczących wszędzie kabli, więc zacisnąłem zęby, siadłem do Eagle'a i zacząłem dziergać płytkę. Pomierzyłem wszystko dokładnie, zamówiłem w JCLPCB i światło dzienne ujrzał taki oto kawałek włókna szklanego: Przede wszystkim zaprojektowałem od razu otwory, którymi mogłem przeprowadzić spod spodu przewody od silników - odpowiednie pady znalazły się zaraz obok, co znacząco ułatwiło lutowanie. Pamiętałem też o tym, by ścieżki, którymi będzie płynął największy prąd zasilający silniki i nadajnik video, były odpowiednio szersze od pozostałych. Nie są to wprawdzie dramatycznie wysokie wartości, ale po co ryzykować. Oprócz dedykowanych złącz na dwa serwa, wyprowadziłem jeszcze dwie dodatkowe serie pinów 5V+GND+SGN w razie, gdybym chciał podłączyć jeszcze więcej serw albo na przykład czujnik odległości. Teraz trzeba było zaprojektować obudowę. Zdecydowałem się na prosty, prostopadłościenny kształt - elegancki, funkcjonalny i - co najważniejsze - dopasowany dokładnie do podwozia, które miałem do dyspozycji. Co ważne, okazało się, że przy odrobinie wysiłku projekty w Fusion 360 można synchronizować z płytkami zaprojektowanymi w Eagle - dzięki temu mogłem "wywiercić" otwory dokładnie w tych miejscach, w których było to potrzebne. Potem pozostało wydrukowanie wszystkiego - długie godziny - i zmontowanie. Dzięki temu, że miałem pod ręką płytkę, montaż był banalnie prosty. Wszędzie przylutowałem żeńskie złącza goldpinowe, serwa przypiąłem kątowymi męskimi pinami (dzięki temu nie miałem problemu ze zmieszczeniem wtyków w obudowie), wszystkie płytki wskoczyły w swoje sloty i to właściwie był koniec. I dobrze, bo mam straszną alergię na lutowanie... Programowania też nie było zbyt dużo, ponieważ mogłem wykorzystać całkiem sporo kodu z poprzedniego projektu. Całość możecie ściągnąć z mojego repozytorium na GitLabie. Jest jednak jedna istotna różnica: zdecydowałem się zrezygnować z odbierania danych z odbiornika RC poprzez PWM, ponieważ FrSky umożliwia odbiór kompletu danych poprzez port szeregowy - SBUS. Pewnym problemem jest to, że jego standard jest... nieco niestandardowy (jest to podobno "odwrócony" UART, czyli tam, gdzie w UART jest 1, w tym formacie jest 0 i vice versa), ale na szczęście istnieje odpowiednia biblioteka, która automatycznie odczytuje dane, przy czym uwaga: nie działa ona na wszystkich mikrokontrolerach zgodnych z Arduino (ale na szczęście działa na Teensy). Co ciekawe, nie nadziałem się w tym projekcie na żadne większe problemy. Było jednak kilka mniejszych, na przykład montaż akumulatora - pierwotnie miał on znajdować się w dedykowanej rynience, ale się w niej najzwyczajniej w świecie nie zmieścił. Nie zależało ni jednak jakoś specjalnie na tym, by się tam ona znajdowała, więc skończyło się na najzwyklejszym rzepie. Musiałem też raz przeprojektować montaż anten odbiornika RC (powinny one znajdować się względem siebie pod kątem 90 stopni dla najlepszego odbioru), ale ogólnie jestem z niego bardzo zadowolony, bo anteny wskoczyły w odpowiednie sloty i trzymają się w nich pod wpływem grawitacji - nie musiałem montować ich na klej, śrubami czy w inny tego typu sposób. Po złożeniu całości okazało się też, że robot bardzo mozolnie porusza się do przodu i dziwnie przy tym terkocze. Okazało się, że oryginalne felgi umieszczały opony bardzo blisko podwozia, przez co opony o nie tarły. Niewiele myśląc, zwymiarowałem felgi dokładnie i wydrukowałem własne - z odpowiednim dystansem. Na powyższych zdjęciach widać już te wydrukowane. Poniżej możecie zobaczyć robocika podczas pierwszych testów w moim starym mieszkaniu. Moja półtoraroczna córka nazywa go "brum brum", ale finalnie ochrzciłem go zgodnie z przyjętą jakiś czas temu konwencją, więc otrzymał imię "Lynx", czyli "Ryś". Koncepcja opierała się na nazywaniu pojazdów zwierzętami, które mniej więcej oddają sposób ich poruszania się - na przykład zbudowane przeze mnie wcześniej quadrokoptery po starcie musiały zawsze w jakiś sposób wylądować (planowo lub nie), uznałem, że tak naprawdę nie latają, tylko kicają, więc otrzymały nazwy "Pchła" (najmniejszy, kupiony w sklepie), "Zając", "Królik" i "Kangur" (ostatni mierzył pół metra - od śmigła do śmigła, a latał na śmigłach 12,8"). Ot, taka ciekawostka. Ale projekt koniec końców się udał! Czego życzę również wszystkim innym amatorom budowania elektronicznych projektów DIY.

- 5 odpowiedzi

-

- 12

-

-

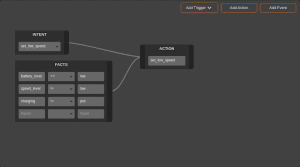

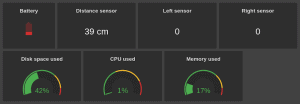

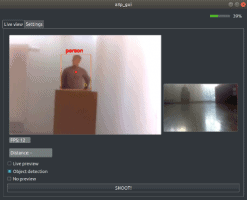

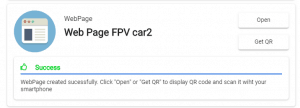

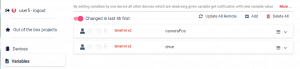

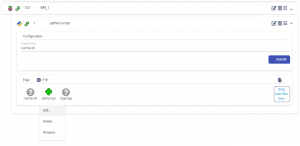

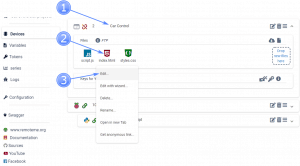

Cześć! Chciałbym podzielić się z Wami projektem rozwijanym przeze mnie równolegle do AgeBota (który zresztą na tejże platformie bazuje) o nazwie Veides. A co to? Głównym celem Veidesa jest umożliwienie każdemu korzystania z dobrodziejstw Sztucznej Inteligencji bez konieczności posiadania zaawansowanej wiedzy na temat działania poszczególnych algorytmów z tej dziedziny, co pozwala skupić się na tworzeniu rozwiązań, a nie rozwiązywaniu problemów. A do czego to? Jednym z założeń Veidesa jest to, aby mógł współpracować z dowolnymi urządzeniami (robotami, robotycznymi ramionami, wszelkimi DIY, Smart Home), którym przyda się trochę inteligencji. Nie ma wymogu posiadania warstwy sprzętowej, więc wszystko zależy od fantazji. Wystarczy połączenie z internetem. A co to potrafi? Jednym z głównych elementów systemu są tzw. przepływy. Określają one wysokopoziomowe zachowanie Waszego robota, urządzenia czy oprogramowania (dalej "agent"), a definiuje się je za pomocą graficznego edytora w konsoli: Przepływy można zdefiniować jako bazę wiedzy każdego agenta, która potem ewoluuje w zależności od środowiska, w jakim agent się znajduje czy w jakie interakcje z nim wchodzi. Uczy się, trochę jak dziecko 🙂 Idąc nieco w przód, wymarzyłem sobie świat, w którym to robot przyrządza i podaje mi rano kawę. Przygotowanie kawy dla nas jest czymś względnie prostym, natomiast dla robota już niekoniecznie. Z jego punktu widzenia jest to dosyć skomplikowana sekwencja czynności do wykonania, gdyż musi posiadać wiedzę na temat środowiska zaczynając od tego gdzie jest czajnik czy ekspres, przez to gdzie są kubki (oraz czy mam jakieś preferencje co do kubka) i ile czasu kawę należy parzyć (jeśli użyje czajnika). Być może znacząco uprościłem, ale myślę, że to oddaje obraz złożoności tego zadania. Jeśli dołożymy zmieniające się, dynamiczne środowisko gdzie ktoś może przestawić czajnik/ekspres lub na drodze do nich pojawi się niespodziewana przeszkoda, to jeszcze bardziej zwiększamy poziom skomplikowania. I tutaj wkracza Veides. Rolą platformy w tym wszystkim jest koordynacja wykorzystywania zgromadzonej wiedzy oraz zdobywania nowej. Nasze zadanie to - w przypadku robota - reagowanie w pożądany sposób "sprzętem" na przychodzące akcje, czyli konkretne instrukcje do zrobienia: Jedź prosto 3 metry Obróć się w lewo o 30 stopni itd... Analogicznie w przypadku innych urządzeń i oprogramowania. Dzięki systemowi możemy lepiej skupić się na tym co chcemy osiągnąć. Powyższą wizję powoli wdrażam. Na początek AgeBot jest w stanie uczyć się pewnych zachowań, może także zapamiętać twarze i przypisać do nich imiona oraz oczywiście posiada wiele innych możliwości, np. reagowanie na krytyczny stan baterii - w czym pomaga Veides. Następnym modułem systemu jest wbudowany czat tekstowy, dzięki któremu mamy możliwość komunikowania się z agentem za pomocą języka naturalnego. Komunikacja jest dwustronna, tzn. można ten kanał wykorzystać do wydawania poleceń ("Skocz po piłkę") oraz do tego, aby agent informował nas o ważnych zdarzeniach ("Chodźcie, Adaś skacze!"). Istnieje także możliwość "poproszenia" o kilka zadań, które wykonają się sekwencyjnie, dodatkowo można te zadania "odkładać" na później (przykład w tym filmie) czy ustawić sobie budzik. Polecenia nie muszą być wykonywane natychmiast. Jednym z kolejnych kroków w rozwoju modułu komunikacji będzie m.in. komunikacja głosowa. Kolejny moduł to kokpit, w którym możemy na żywo obserwować działanie agentów dostosowane do naszych potrzeb: A jak się tego używa? Do projektu spisana jest dokumentacja zawierająca najważniejsze informacje (m.in. tutorial jak zacząć), które w miarę możliwości uzupełniam. Zarówno dokumentacja, konsola oraz moduł czatu wspierają obecnie jedynie język angielski. Veides dostarcza SDK dla Pythona, C oraz dla aplikacji ROS paczkę zawierającą node (gotowy przykład znajduje się na GitHubie). Bilbioteki SDK dla innych technologii (NodeJS, Java (również w kontekście Androida), Arduino oraz ROS2) zostaną zaimplementowane w niedalekiej przyszłości, jeśli będzie taka potrzeba. A kiedy to? Veides jest aktualnie w fazie alfa, jednak minimalna ilość funkcjonalności jest już dostępna niepublicznie. Użytkownikom forum chcącym sprawdzić jak Veides działa w praktyce, chętnie dam dostęp do systemu na miesiąc (poproszę zgłosić się w wiadomości prywatnej), a jeśli projekt się spodoba, po miesiącu zastanowimy się co dalej 🙂 W zamian jedyne o co bym prosił to podzielenie się opinią o projekcie. Takie możliwości jak nauka zachowań czy twarzy na razie są dostępne tylko dla AgeBota, ale oczywiście zostanią wraz z rozwojem platformy udostępnione. A co dalej? Projekt rozwijam systematycznie w ramach hobby, co sprawia mi mnóstwo frajdy. Mam wiele pomysłów bezpośrednio dotyczących rozwoju AgeBota jak i tych dotyczących ekosystemu Veidesa, które powoli wcielam w życie. Na razie konkretnych dat nie jestem w stanie podać, ale na pewno w tym wątku będę Was na bieżąco informował o wszelkich postępach. Zachęcam także do śledzenia wątku AgeBot. Jeśli macie jakieś pytania, opinie, wątpliwości - zapraszam do dyskusji 🙂

-